Как сделать правильный файл robots, чтоб «удивить» Яндекс и Google

Всем привет! Любой сайт должен иметь файл роботс.тхт, чтоб поисковые машины смогли быстро проиндексировать их ресурс и вебмастер получал посетителей с поисковой выдачи в дальнейшем.

Всем привет! Любой сайт должен иметь файл роботс.тхт, чтоб поисковые машины смогли быстро проиндексировать их ресурс и вебмастер получал посетителей с поисковой выдачи в дальнейшем.

В статье я расскажу, как просто сделать robots.txt для wordpress, используя нехитрые способы его составления, а также что допускают 95% вебмастеров составляя этот файл неправильно.

Содержание:

Правильный robots.txt для wordpress: что это?

Лучше, чем этот короткий ролик никто не расскажет, что это за файл.

Среди «бывалых» вебмастеров из давно известно, что файл robots.txt на сайте, будь то движок wordpress или joomla, обязателен.

Именно его в первую очередь посещают поисковые роботы, а не как не корень вашего сайта //сайт.ru/.

Файл robots.txt, должен располагаться по адресу //ваш сайт/robots.txt и ни в коем случае его нельзя переименовывать, как-то иначе от robots.txt.

robots.txt - корневой файл, который указывает поисковым машинам, что индексировать, а чего не отображать в поисковой выдаче.

Критическая ошибка многих вебмастеров при создании файла robots.txt

Прежде чем озвучить ошибку, давайте разберёмся, как правильно настроить robots.txt для сайта wordpress.

В интернете есть ряд поисковых систем, но наиболее популярные из них это Google и Яндекс. Остальные мы в этой статье рассматривать не будем, так как они практически идентичны с лидерами интернета.

Итак, как в файле robots.txt обратиться к роботу Яндекс?

Это сделать очень просто нужно всего лишь прописать строчку ниже в файл robots.txt и все остальные правила будут действовать только для робота Яндекс. При обращении к яндексу, пишем:

User-agent: Yandex

Строка User-agent: обращение к определённому поисковику, как вверху к Яндексу,

а если поставить *, будет означать ко всем поисковым машинам будут относиться эти

правила нижнего регистра.

Для того, чтоб закрыть от индексации какую-либо папку или файл достаточно в robots.txt

прописать этот код: «Disallow: папка», для того, чтоб открыть доступ к файлу «allow: имя файла»

Задание, где я плачу деньги за правильный ответ на вопрос!

Вы хорошо разбираетесь в этой теме? Вам скучно и хочется денег? Тогда предлагаю ответить в комментариях на вопрос: как поступит Яндекс в этом случае, будет он индексировать папку /wp-admin либо нет?

User-agent: Yandex Allow: /wp-admin Disallow: /wp-admin Sitemap: https://seovpmr.ru/sitemap_index.xml

Если вы правильно ответите, развёрнуто, на вопрос, вас ждёт денежный приз на кошелёк webmoney. Все желающие принять участие в конкурсе, пишите свой номер кошелька WMR. Победителя мы объявим в конце этого поста.

Серьёзный, рабочий файл robots.txt для wordpress

Что должно входить в правильный robots.txt для wordpress

- Обращение к поисковому роботу

Правильный адрес сайта HOST:Больше не актуально- Адрес карты сайта

- Disallow: / - места, что запрещено индексировать

- Allow: / - места, которые нужно индексировать

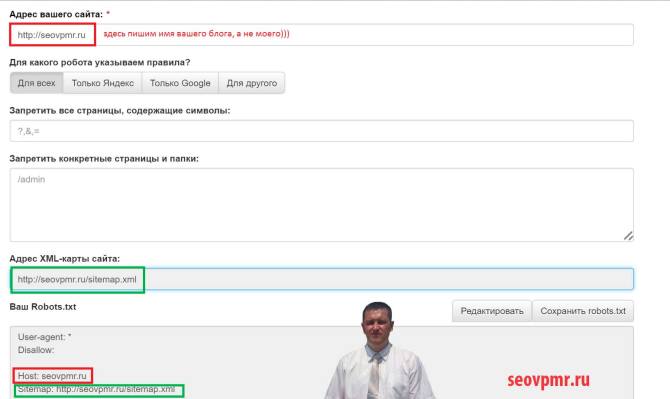

Что такое allow и Disallow мы рассмотрели выше, теперь я хочу поговорить об атрибуте HOST, и рассказать вам для чего он нужен в файле robots.txt.

Хост — зеркало вашего сайта, точнее, то, как поисковому роботу выдавать сайт в поисковой выдаче с WWW. или БЕЗ WWW.

Среди оптимизаторов одно время бытовало поверье, что сайты с WWW более кликабельные, чем без WWW, как это на самом деле вы, можете проверить проведя собственный эксперимент, для этого достаточно прописать строчку ХОСТ в файле robots.txt:

Host: ваш сайт.ru /** без www

либо

Host: WWW.ваш сайт.ru /** c www

Сайт в результатах поиска БЕЗ WWW.

В общем, проводите эксперименты и не забывайте делиться с ними в комментариях к этой статье.

Остаётся рассказать о ещё одной строчке:

Sitemap: //ваш сайт.ru/sitemap.xml

В общем, эта страничка, где хранятся все ссылки на доступные роботу странички. Сильно не заморачивайтесь просто скопируйте готовый файл robots.txt, так как эта отдельная статья, которую я обязательно напишу на блоге.

Теперь пару слов об ошибке, как и обещал. Запрещая поисковому роботу, ту или иную папку или файл к индексации это не говорит о том, что он её не видит просто не покажет в результатах поисковой выдачи, но обязательно там побывает.

Помните об этом, товарищи! И максимально защищайте сайты, чтоб не распространять нежелательную конфиденциальную и прочую информацию. Просто укажите роботу, какую папку не нужно публично демонстрировать в файле robots.txt.

Как просто составить файл robots.txt для сайта wordpress — новичку

Ребята, я тут не буду палить фишки и прочее, так как это должен знать каждый мало-мальски уважающий себя веб-мастер. В общем, если вы хотите скачать готовый правильный файл robots.txt для wordpress, то копируем код ниже:

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /feed/ Disallow: */feed Disallow: */trackback Disallow: */comments Disallow: /*? Disallow: /*?* Disallow: /tag Sitemap: https://ваш сайт/sitemap.xml User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/

(Не забывайте менять поле «ваш сайт» на свой «РОДНОЙ»)

[help]Совет: если ваши статьи оканчиваются наподобие

//ваш домен/?p=123,

то не прописывайте это правило: [/help]

11 Disallow: /*? 12 Disallow: /*?*

Так как оно запретит индексацию вашего сайта! Просто удалите эти две строчки либо исправьте адреса статей на ЧПУ (человека понятные урлы).

Исправляем: переходим в консоль админ панели wordpress в раздел настройки — постоянные ссылки и выбираем поле произвольно, где прописываем следующее:

/%category%/%postname%/

Вот и все, теперь нужно дождаться переиндексации и статья открывается по адресу:

//ваш сайт/categor/kak-sdelat-pravilnyj-robots-txt-dlya-wordpress/

Напомню раньше было так:

//ваш сайт/optimization/?=25689

User-agent: Googlebot-Image — робот Google, индексирующий картинки

User-agent: YandexImages — робот Яндекс, индексирующий картинки

Внимание! Чтоб не создавать дубли, читайте статью целиком и вы узнаёте, как избавиться от дублей страниц в поисковой выдаче Яндекс и Google.

Урок, как сделать самостоятельно правильный robots.txt без особых навыков

Ну а теперь шедевр мирового создания файла robots.txt с нуля, без особых знаний и опыта.

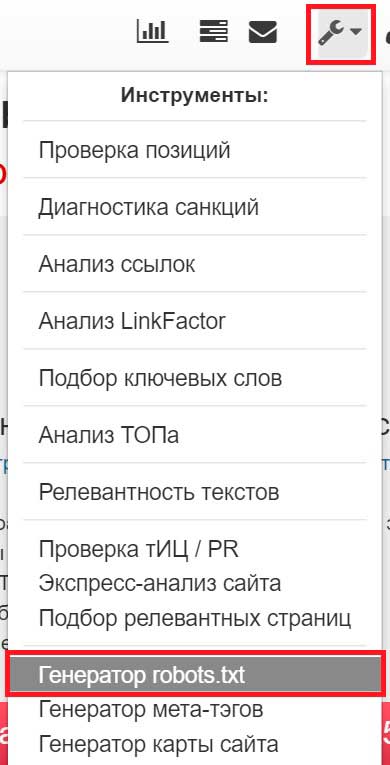

Для начала берём и регистрируемся по этой , как это делать вы уже наверно давно умеете, так что кто не знает, тому домашнее задание.

Переходим на эту (смотрим скриншот ниже), после регистрации на сайте выше.

Как вы понимаете мы попали на онлайн-генератор файла robots.txt

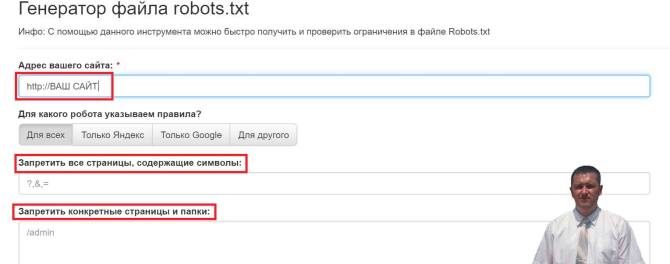

Теперь давайте по каждой строчке по отдельности.

- Адрес вашего сайта — просто пропишите свой домен. На скриншоте отмечено красной рамкой.

2. Адрес XML — карты сайта — прописываем //ВАШ САЙТ/sitemap.xml (на скриншоте отмечено зелёной рамкой).

Дальше нам нужно запретить отображения папок и файлов, но вопрос в том, какие именно стоит закрывать от индексации?

Задумались?

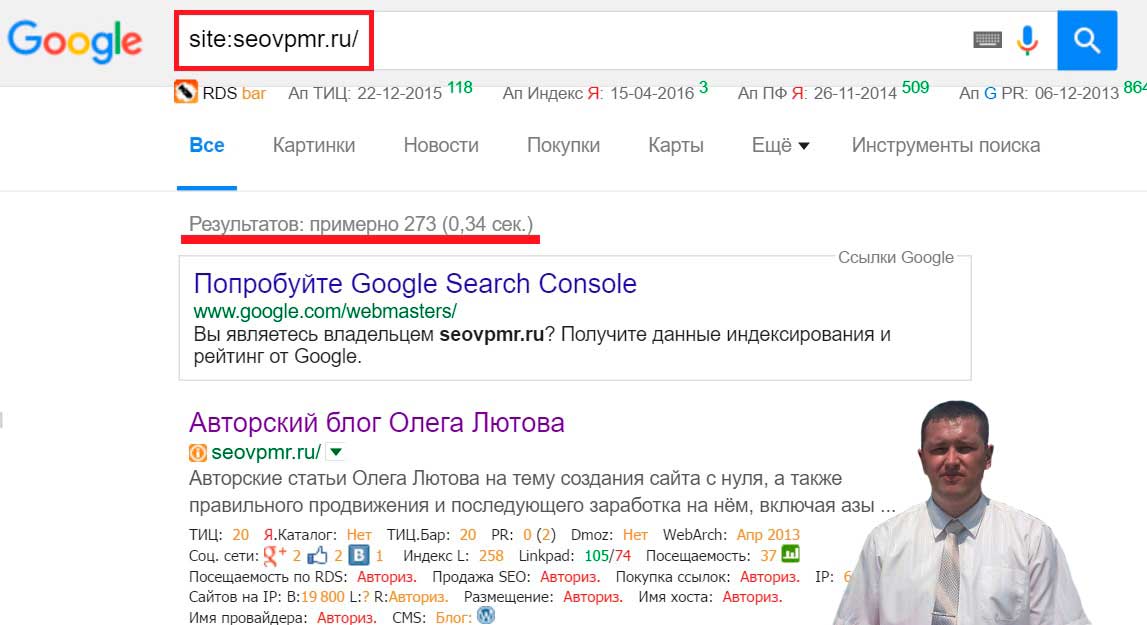

Всё очень просто, если вы не знаете, какие именно файлы и папки нужно закрыть, то нечего ни делайте в течение одной — трёх недель, а потом заходим в поисковую систему Google или Яндекс и прописываем следующее:

site:seovpmr.ru/ - отобразит все проиндексированные странички.

site:seovpmr.ru/& - отобразит только основную выдачу.

Я вам покажу свою статистику, которую мне нужно срочно исправлять, так как я провёл эксперимент, но об этом не в этой статье.

Смотрим показатель Google, вбивая в поиск

<strong>site:ваш сайт/ и site:ваш сайт/&</strong>

Как можно увидеть на скриншоте в выдаче 273 странички, но если взять основную выдачу Google, то можно сразу понять, тот факт, что robots.txt заполнен не корректно для Google. Так как сказать Google, что он «неправ»? Мы помним, что правила, которые мы указали относятся только к Яндексу, так как мы обратились в файле robots.txt к нему:

User-agent: Yandex

При желании можно написать правила и для Google, а также оставшихся поисковых роботов:

User-agent: *

Я не буду писать правила для Google в файл robots.txt, а вынесу эти правила в отдельный специальный файл .htaccess, где и склею эти дубли.

Но если вам, к примеру, нужно скрыть определённую папку или файл, то допишите в файл robots.txt:

User-agent: * Disallow: /имя вашей папки

Также очень рекомендую воспользоваться специальным инструментом для создания файла robots.txt для вашего сайта, в том числе и joomla и wordpress.

Просто в строке:

Запретить все страницы, содержащие символы:

Укажите, что не нужно индексировать роботу, к примеру, все странички, где есть вопросительный знак,

и пишите «?», без кавычек.

А в строчке:

Запретить конкретные страницы и папки:

Укажите имя конкретной папки, выбрав при этом нужного поискового робота Яндекс, Google, другой.

Проверка файла robots на корректность заполнения и работоспособность

После чего остаётся только проверить файл робот на правильность его заполнения. Тут рекомендую воспользоваться инструментом Яндекс вебмастер:

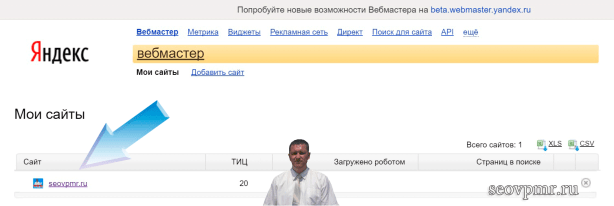

- Переходим в личный кабинет вебмастера Яндекс, где вы уже должны быть зарегистрированы. Ваш сайт уже добавлен в систему!

- Переходим по нужному вам сайту, так как их может быть несколько в кабинете.

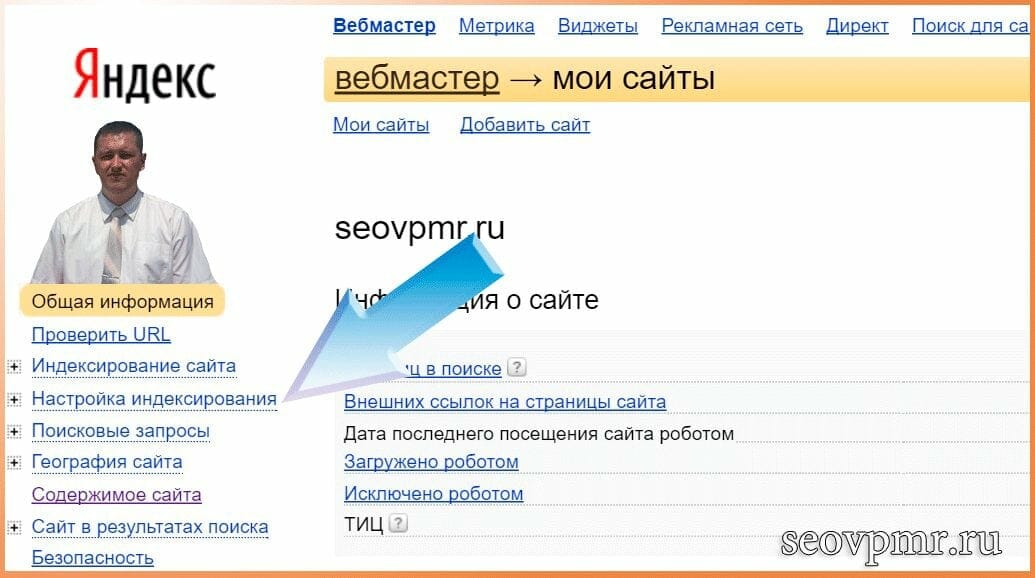

- Открываем страничку «Настройка индексирования»

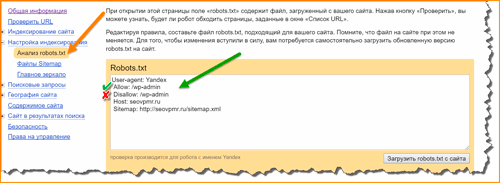

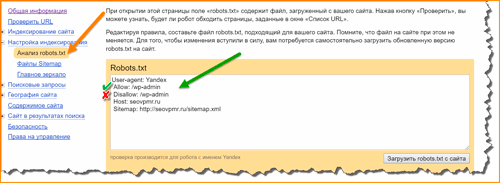

- Переходим в подраздел Настройка индексирования — анализ robots.txt анализ-robots

- Жмём кнопку «загрузить robots.txt c сайта», как показано на скриншоте

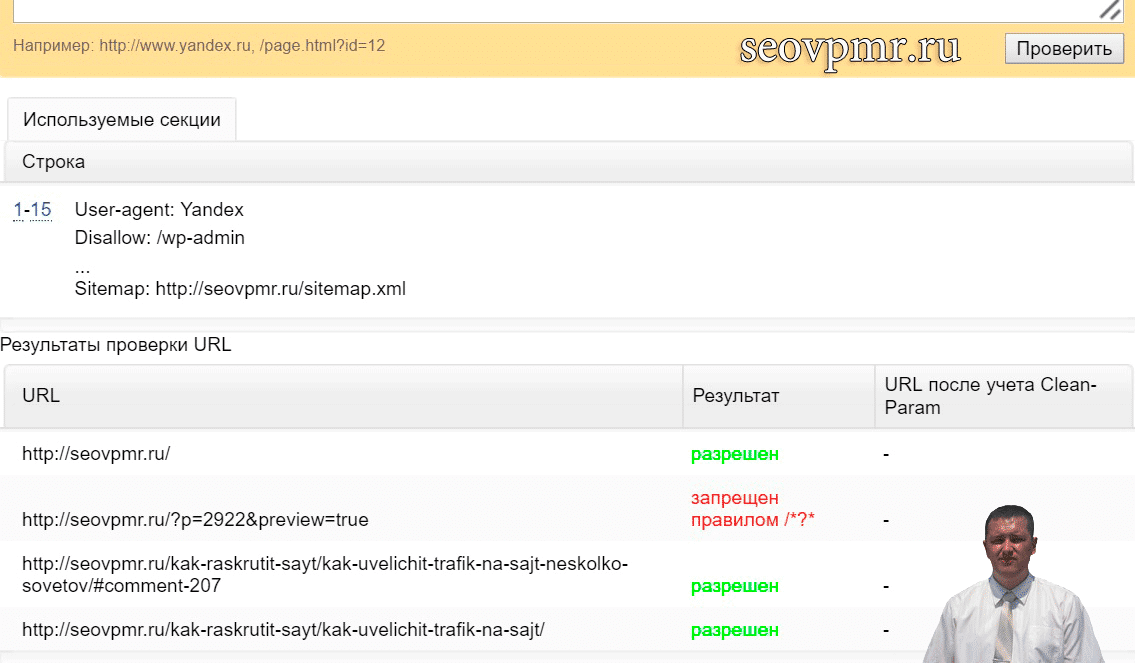

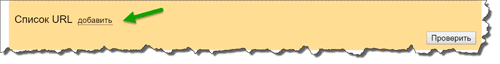

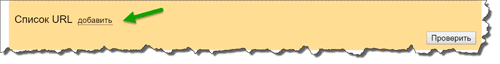

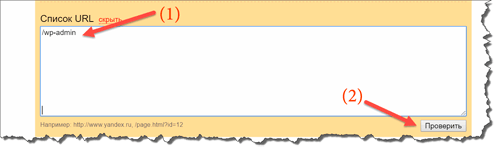

- Жмём кнопку «Список URL» и вписываем адреса нашего сайта начиная с главной.

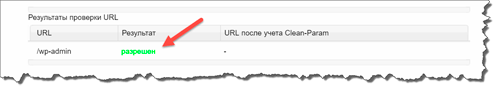

Как видно на скриншоте у меня три ссылки работают корректно, одна запрещена правилом «Disallow: /*?*», что нам и требовалось доказать.

Давайте посмотрим статистику Google основной выдачи (site:seovpmr.ru/&), после внесения изменений в файл robots.txt, так как для google мы ничего не указывали роботу:

Как видите, в результате поиска всего 161 страничка, вместо 273. Как-то на дубли смахивает, неправда ли? Так вот чтоб не растягивать статью ещё на километр, советую ленту и получить одним из первых статью, как сегодня избавиться от дублей своего сайта. Хочу, сразу сказать, что от дублей нужно было избавляться ещё вчера, тогда вас ждёт успех.

Ребята, а пока ждёте новую статью, задавайте вопросы в комментариях к статье.

Ответ конкурса

В статье, я давал задание ответить на вопрос, как яндекс будет реагировать на неправильно составленный файл robots.txt, вот и пришло время рассказать об этом.

Первый, кто ответил на этот вопрос правильно это Игорь Черноморец и его уже ждёт приятный денежный приз от меня, надеюсь, он ещё со мной свяжется.

А вот, как просто можно проверить, что Игорь правильно ответил в комментариях на поставленный вопрос:

- Открываем яндекс вебмастер и переходим в раздел проверка файла robots.txt, где и вставляем наш некорректный файл.

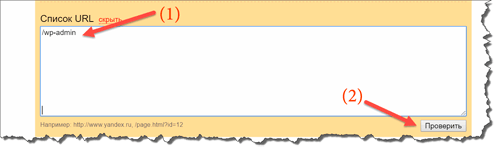

- Следующим действием добавим путь к нашей папке /wp-admin здесь:

- Следующим шагом мы жмём кнопку «проверить».

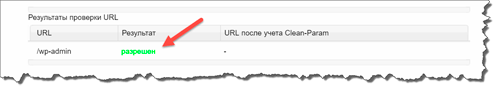

- Смотрим результат

Как показала практика Игорь был прав, что Яндекс отдаёт приоритет атрибуту /allow. На сегодня у меня всё, до встречи.

Ответ конкурса

В статье, я давал задание ответить на вопрос, как яндекс будет реагировать на неправильно составленный файл robots.txt, вот и пришло время рассказать об этом.

[note]Первый, кто ответил на этот вопрос правильно это Игорь Черноморец и его уже ждёт приятный денежный приз от меня, надеюсь, он ещё со мной свяжется. [/note]

А вот, как просто можно проверить, что Игорь правильно ответил в комментариях на поставленный вопрос:

- Открываем яндекс вебмастер и переходим в раздел проверка файла robots.txt, где и вставляем наш некорректный файл.

- Следующим действием добавим путь к нашей папке /wp-admin здесь:

- Следующим шагом мы жмём кнопку «проверить».

- Смотрим результат

Как показала практика Игорь был прав, что Яндекс отдаёт приоритет атрибуту /allow.

На сегодня у меня всё, до встречи.

|

Бала ли вам статья полезной? |

Ааааа, понял 🙂 Ну я выбираю альтернативный приз, вместо денег. Немного позже дам ссылку на статью и укажу ключ.

Огромное спасибо Олег, неожидал 🙂

Хорошо, как определитесь напишите. Внутренняя перелинковна намного важнее, чем пару копеек — уважаю выбор.

В смысле? Куда и где дать ссылку на этот комментарий? Вы имеете ввиду поделиться в соц. Сетях?

Напишите свой кошелёк webmoney (wmr), куда я могу скинуть ваш выигрыш, в виде 50 рублей за правильный ответ на конкурс. Можете прислать номер и в комментариях, я его публиковать целиком не буду, некоторые цифры я скрою от посторонних.

Также вместо приза вы можете получить алтернативный подарок от меня бесплатно:

Вы мне даёте ссылку на вашу статью и ключ, по которому вы хотите попасть в топ поисковых машин, я анализирую внутреннюю перелинковку по вашему сайту и даю рекомендации с точки зрения поисковика Яндекс (Алгоритмы поиска я не раскрываю просто пишу какая статья должна ссылаться и по какому слову на вашу указанную).

Привет Олег. Классная инструкция про файл robots.txt. На мой взгляд, одна из лучших в сети. Круто!

По поводу твоего вопроса (конкурс)…

Яндекс проиндексирует папку, так как у него всегда приоритет на команду allow.

Надеюсь, что я ничего не перепутал 🙂

Здравствуйте, Игорь. Действительно, вы правы, как это легко проверить я отвечу внизу своего поста профайл robots.txt. Если есть желание получить 50 рублей на webmoney от меня за правильный ответ конкурса, напишите мне свой кошелёк и дайте ссылку на этот комментарии. (Кошелёк публиковаться не будет). Ещё раз спасибо за участие в конкурсе.